La guerre des dimensions perdues : quand l'intelligence humaine s'effondre face à la complexité

L'orgueil du stratège

Il existe un paradoxe fondamental dans la manière dont les humains abordent les conflits armés : nous nous croyons capables de maîtriser des systèmes d'une complexité vertigineuse alors même que nos outils cognitifs nous condamnent à une simplification grotesque de la réalité. L'histoire militaire n'est pas seulement un catalogue de victoires et de défaites ; c'est avant tout un musée des illusions perdues, une collection d'erreurs systémiques nées de notre incapacité structurelle à penser au-delà d'un nombre limité de dimensions simultanées.

Le général qui déploie ses divisions sur une carte croit manipuler l'espace et le temps. Le stratège qui évalue le rapport de forces pense maîtriser les variables essentielles. Le politique qui décide d'entrer en guerre s'imagine avoir pesé tous les paramètres. Tous se trompent, non par manque d'intelligence ou de bonne volonté, mais parce que leur appareil cognitif est structurellement inadapté à la tâche qu'ils prétendent accomplir.

PowerPoint ou l'appauvrissement méthodique de la pensée

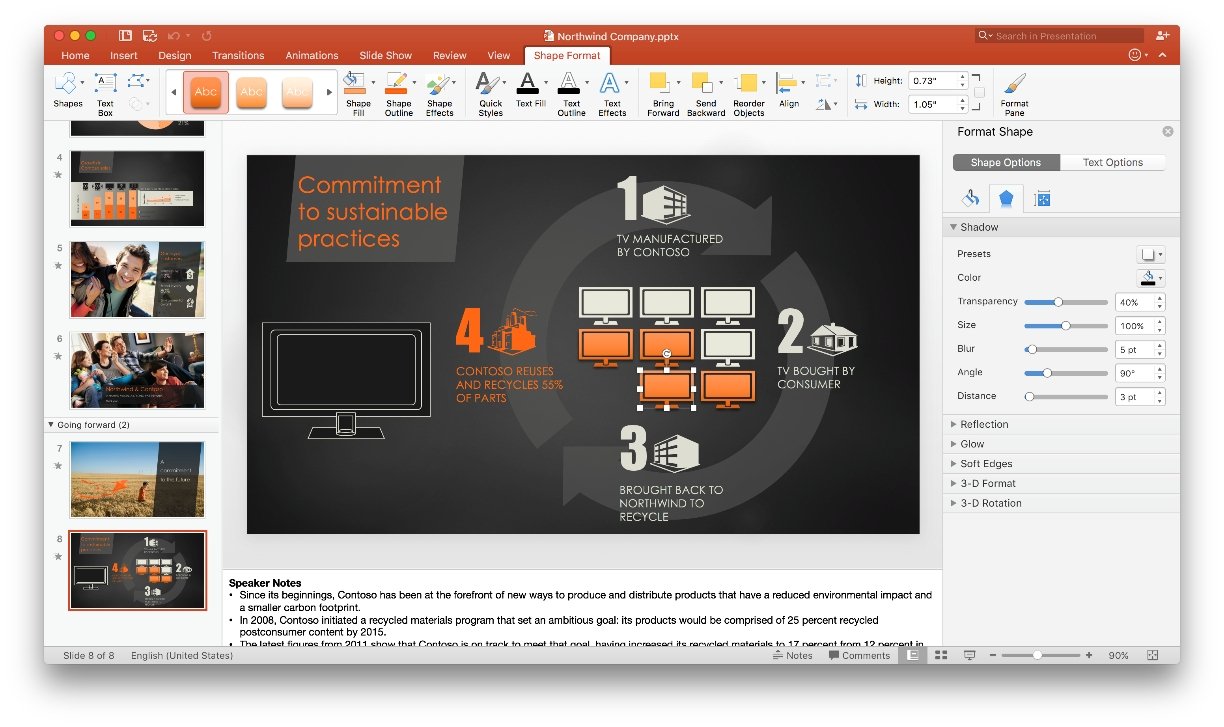

Il est devenu courant, dans les états-majors modernes, de synthétiser des situations stratégiques complexes en quelques diapositives PowerPoint. Ce qui apparaît comme un exercice de clarté constitue en réalité une mutilation intellectuelle systématique. Chaque slide ne peut représenter que deux dimensions à la fois : le temps contre le coût, la force contre l'espace, le risque contre le bénéfice. La succession des diapositives ajoute certes une dimension supplémentaire, temporelle ou thématique, mais cette architecture même interdit toute vision globale.

Le général H.R. McMaster, dans sa critique acerbe de cette culture du briefing, avait dénoncé ce qu'il appelait « la guerre en PowerPoint », où des officiers en venaient à confondre la représentation simplifiée avec la réalité qu'elle prétendait décrire. La campagne d'Afghanistan a fourni d'innombrables exemples de cette dérive : des présentations soigneusement construites prédisaient des progrès linéaires dans des domaines isolés — sécurité, gouvernance, développement économique — sans jamais pouvoir intégrer les interactions non linéaires entre ces dimensions, ni les boucles de rétroaction qui transformaient chaque succès apparent en source de complications imprévues.

L'embedding ou la révolution géométrique des machines

Pour comprendre l'ampleur de notre handicap cognitif, il est éclairant de considérer la manière dont les grands modèles de langage traitent l'information. Ces systèmes effectuent une opération appelée embedding, qui consiste à projeter chaque concept, chaque mot, chaque idée dans un espace mathématique comportant des centaines, voire des milliers de dimensions. Dans cet hyperespace, la proximité géométrique traduit la similarité sémantique, les directions correspondent à des relations conceptuelles, et des patterns invisibles à l'œil humain deviennent des structures exploitables.

Cette approche permet aux machines d'identifier des connexions que notre pensée limitée ne peut concevoir. Là où nous voyons des catégories étanches — le politique, l'économique, le militaire, le social — l'algorithme perçoit un continuum de relations dans un espace où ces distinctions n'ont plus de sens. Les analogies profondes, les corrélations contre-intuitives, les dépendances cachées : tout cela émerge naturellement d'une géométrie que notre cerveau est incapable de visualiser.

Les guerres que nous n'avons pas comprises

L'invasion de l'Irak en 2003 illustre tragiquement cette myopie dimensionnelle. Les planificateurs américains avaient modélisé avec précision la dimension militaire : rapport de forces, capacités de projection, vulnérabilités de l'adversaire. Ils avaient également considéré, quoique superficiellement, la dimension politique (renversement du régime), économique (pétrole) et humanitaire (libération du peuple irakien). Ce qu'ils n'avaient pas saisi — ce qu'ils ne pouvaient pas saisir avec leurs outils — c'était l'entrelacement de ces dimensions avec des dizaines d'autres : les équilibres confessionnels séculaires, les structures tribales, les économies informelles, les traumatismes collectifs, les réseaux de patronage, les identités régionales, les influences iraniennes, les dynamiques de vendetta, les effets de la dissolution de l'armée sur des centaines de milliers de jeunes hommes armés et humiliés.

Chacun de ces facteurs était connu individuellement. Des experts les avaient documentés, des rapports les avaient mentionnés. Mais l'absence d'un espace géométrique commun où intégrer ces dimensions condamnait les décideurs à les traiter séparément, en « lignes d'eau » (stovepipes), comme des problèmes distincts appelant des solutions distinctes. La reconstruction économique était confiée à une agence, la formation des forces de sécurité à une autre, la gouvernance à une troisième. Chaque ligne d'eau optimisait ses propres métriques sans percevoir comment ses actions interféraient avec celles des autres.

L'héritage cartésien et ses ravages

Cette approche compartimentée n'est pas accidentelle. Elle découle directement de la méthode analytique promue par Descartes, qui recommandait de « diviser chacune des difficultés en autant de parcelles qu'il se pourrait et qu'il serait requis pour les mieux résoudre ». Cette prescription méthodologique, révolutionnaire au XVIIe siècle pour l'étude des phénomènes mécaniques, est devenue un carcan intellectuel lorsqu'elle a été appliquée à des systèmes complexes où les interactions entre composants importent davantage que les composants eux-mêmes.

Les armées modernes ont érigé cette approche en doctrine. L'organisation en branches (infanterie, artillerie, génie, transmissions), la séparation entre fonctions opérationnelles et fonctions de soutien, la distinction entre niveaux tactique, opératif et stratégique : tout concourt à fragmenter la réalité en tranches gérables, au prix d'une perte irrémédiable de la vision d'ensemble. Les officiers d'état-major deviennent des spécialistes de leur domaine, parfaitement capables d'optimiser leur parcelle, structurellement incapables de percevoir les effets systémiques de leurs décisions.

Quand les dimensions s'additionnent comme des pommes et des bananes

Il arrive certes que les planificateurs militaires tentent d'élargir leur champ de vision. L'approche dite « globale » ou « interagences » prétend intégrer les dimensions économique, politique, diplomatique, informationnelle, militaire et civile. C'est un progrès apparent, mais qui bute sur un obstacle fondamental : ces dimensions ne partagent pas d'unité de mesure commune, pas d'espace géométrique homogène où elles pourraient être combinées de manière cohérente.

Comment additionner un gain diplomatique et une perte économique ? Comment soustraire un risque politique d'un avantage tactique ? Ces grandeurs sont aussi incommensurables que des pommes et des bananes. Faute de pouvoir les intégrer véritablement, les décideurs se contentent de les juxtaposer, d'en dresser des tableaux comparatifs, d'en discuter séparément lors de réunions successives. La synthèse finale, quand elle existe, repose sur l'intuition du chef — c'est-à-dire sur un processus cognitif lui-même limité, parasité par ses biais, ses émotions, ses ambitions personnelles et ses angles morts.

Les effets secondaires ou la vengeance de la complexité

Cette incapacité structurelle à modéliser la complexité produit un phénomène récurrent dans l'histoire militaire : les effets secondaires des interventions dépassent souvent, et parfois de très loin, les effets recherchés. La guerre de Libye de 2011, conçue comme une opération limitée de protection des populations civiles, a déstabilisé l'ensemble du Sahel, alimenté des flux migratoires massifs vers l'Europe, dispersé des arsenaux entiers entre les mains de groupes armés, et créé un chaos durable dont les conséquences continuent de se déployer une décennie plus tard.

Ces résultats n'étaient pas imprévisibles au sens absolu ; ils étaient simplement invisibles dans l'espace conceptuel restreint où la décision avait été prise. La question posée était : « Pouvons-nous empêcher Kadhafi de massacrer les habitants de Benghazi ? » La réponse militaire était affirmative. Mais cette question unidimensionnelle masquait les dizaines de dimensions non interrogées : Que devient l'armée libyenne dissoute ? Comment réagissent les tribus marginalisées ? Où vont les armes ? Que font les migrants subsahariens bloqués en Libye ? Comment les groupes jihadistes exploitent-ils le vide ? Autant de questions qui n'entraient pas dans le cadre du PowerPoint de planification.

Le schéma se répète inlassablement : l'Irak a renforcé l'Iran qu'il était censé contenir. La Libye a déstabilisé le Mali qu'elle devait sécuriser. Le soutien aux moudjahidines afghans contre l'URSS a créé les conditions d'émergence d'Al-Qaida. Ce n'est pas de la malchance. C'est la conséquence mécanique d'actions optimisées dans un nombre trop limité de dimensions, produisant des effets dans de nombreuses autres dimensions non modélisées.

Vers la fin de l'empirisme stratégique ?

L'espoir de sortir de cet empirisme existe. Les technologies d'intelligence artificielle, et notamment les techniques d'embedding, disposent du potentiel pour conduire des simulations de réalités qui dépassent nos capacités cognitives. Elles pourraient explorer les effets de second et de troisième ordre préalablement à tout engagement, identifier des interactions que notre pensée cloisonnée ne peut concevoir, et révéler les conséquences probables de nos décisions dans un hyperespace que nos cerveaux sont incapables d'appréhender.

Nous sommes entrés dans le XXIe siècle avec une opportunité historique : la fin possible de l'empirisme stratégique. Ne plus apprendre seulement de nos erreurs — les anticiper. Ne plus découvrir les effets secondaires une fois qu'ils se sont matérialisés en catastrophes — les modéliser avant qu'ils ne surviennent. Ne plus naviguer à l'aveugle dans un hyperespace dont nous ne percevons que des ombres — disposer enfin d'instruments capables de cartographier ce que nos sens ne peuvent percevoir.

La question morale

Mais cette promesse technologique se heurte à un obstacle qui n'est plus technique : il est moral. Ces outils de simulation existent déjà, sous des formes encore imparfaites mais fonctionnelles. Et l'expérience montre que lorsque les simulations contredisent nos intentions, la tentation est forte d'ajuster les paramètres jusqu'à obtenir la « bonne » réponse — celle qui confirme ce que nous avions déjà décidé de faire.

La question n'est donc plus de savoir si nous pouvons développer des outils capables de modéliser la complexité stratégique. La question est de savoir si nous aurons l'honnêteté intellectuelle d'accepter ce qu'ils nous diront. Saurons-nous écouter ce que nous ne voulons pas entendre ? Saurons-nous renoncer à une intervention lorsque les simulations en prédisent l'échec, même si cette intervention est politiquement désirable ? Saurons-nous résister à la tentation de trafiquer les modèles pour qu'ils produisent les conclusions que nous espérons ?

L'histoire de l'humanité en matière de guerre n'incite guère à l'optimisme. Mais reconnaître nos limitations cognitives est peut-être le premier pas vers une sagesse stratégique véritable — une sagesse qui consisterait parfois à ne pas agir, ou à agir autrement que notre intuition tridimensionnelle nous le suggère.